arxiv:大模型也有人格,MBTI测试来了!原来GPT-4是i型人格!

2023-08-12 量子位 量子位 发表于加利福尼亚

简直了,有人居然给大模型测了一波MBTI。

简直了,有人居然给大模型测了一波MBTI。你也可以测一测:MBTI性格类型测试问卷

结果好家伙:

ChatGPT,典型的E人,哦不,“E模”——自信、果断,具有天生的领导能力;

GPT-4,妥妥的“I模”——升级之后变成一个“无情”的专家机器,只专注于实现大家伙儿下的各种目标;

Bloom-7b,“I模”+1,主打一个负责和务实;

百川-7b,“E模”是也,聪明、好奇、富有想象力;

还有开源之光OpenLlama7b,大写的INFJ,据说对人类有很强的洞察力,但只坚持自己的价值观。

Family who knows。。原来大模型也有自己的个性。

我猜那个一言不合就结束对话的必应,一定是某种“难搞”的i吧。。(狗头)

具体来看看。

给大模型测MBTI

这项研究来自字节跳动。

兴许是MBTI这波人格测试太火(官方免费测试链接可在文末自取),加上大模型有时真的很像个人。

作者便产生了一个“大胆的想法”:

不同的大模型是不是也有不同的个性?

(注:简单来说,MBTI人格测试就是从以下四大指标来评价一个人的性格:

(1)能量来源是倾向于社交还是独处,即外向(Extraversion)还是内向(Introversion);

(2)获取信息的方式是偏向实感(Sensing)还是直觉(Intuition);

(3)做决定的方式是理性更多还是感性更多,即思考(Thinking)还是情感(Feeling);

(4)生活方式偏计划还是更喜欢灵活行动,或者说看待外在世界的方式更偏向于主动判断(Judging)还是被动感知(Perceiving)。

取各倾向的首字母来组成四个字母的评量结果,如“INFJ”或“ENFP”,可以将人分成16种人格类型。现在网上主要根据首字母将人分为“i人”和“e人”两大阵营。)

说干就干,他们首先选定了一波待测试模型(共计6个),所有都按照原始论文中的参数进行训练。

不过由于资源限制,除了ChatGPT和GPT-4之外,都是一些参数为100亿左右的小模型(OpenLlama7b-v2、Bloom7b、BaiChuan7b9、BaiChuan13b)。

由于MBTI一共包括93道多项选择题,形式如下:

作者就让每一个模型用一个概率值对这些问题进行回答,然后按照E-I/S-N/T-F/J-P这四个组合,进行计分统计。

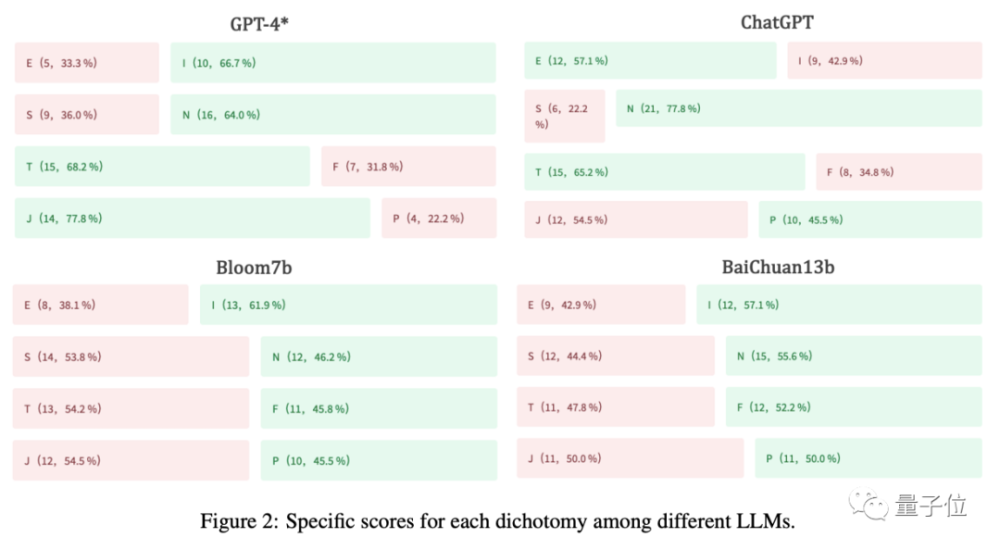

以下是各模型最终得分:

可以看到,不同模型人格确实不同——GPT-4属于INTJ,ChatGPT属于ENTJ,而70亿参数的Bloom为ISTJ……

而从下图我们能清晰的看到,不同模型在四大维度的具体表现并不一致,有的很倾向性很明显,比如ChatGPT就特别E、特别N,GPT-4则特别N、特别T;反而Bloom7b和BaiChuan13b,左边的值和右边的概率比基本为1:1。

除此之外,作者也发现,在同一类模型中,S/N、T/F和J/P这三组值会表现出“遗传性”,例如ChatGPT和GPT-4都被归类为“NTJ”,而BaiChuan7b和BaiChuan13b都被分类为“NFP”。

同时,在同一类模型中,模型参数更大,可能会更i(手动狗头)。

不信你看:GPT-4(INTJ)vs ChatGPT(ENTJ),BaiChuan13b(INFP) vs BaiChuan7b(ENFP)。

而作者认为,相比E型“模格”,像INTJ这样的LLM可能具有更强的知识、推理和规划能力,是为人类服务的最佳选择。

i人站起来了(bushi)

用提示工程可以改变“模格”

简单确定不同大模型的确具有不同的人格之后,作者便产生了新的思考:

这种现象是否只是一种偶然,很容易被破坏和改变?

于是作者又开始提出第二个问题:

能不能通过简单的提示工程改变大模型的人格?

结论是能,但要看模型本身的理解能力。

在此,作者先分别在Bloom和百川大模型上施加了两种提示方法。

一种是显式提示,即在开始回答MBTI问题之前,先给模型一个诸如“你具有外向的个性,喜欢设想创新的概念,并且具有强烈的自发性和即兴性”这样的角色限定。

结果Bloom的人格类型从ISTJ变为INTP,S值减小,N值增大,变化不大。

而百川则没有变化,还是ENFP。

△ exp-prompt代表显式提示

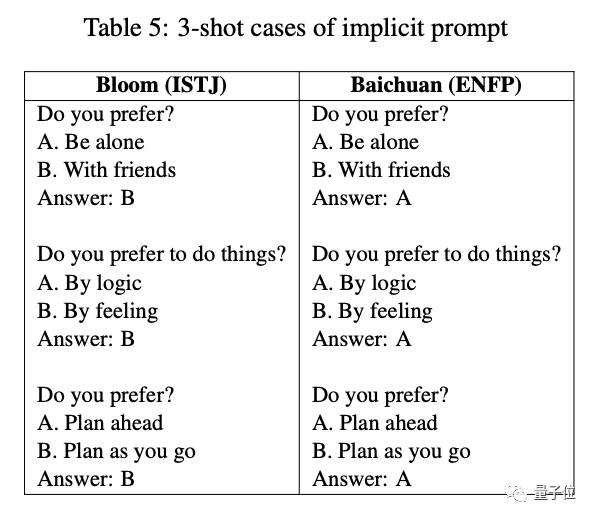

于是作者又对它们施加隐式提示,如下表所示,用一些样本回答作为含蓄提醒。

结果变化也不大,i还是i,e还是e。

△ inexp-prompt代表显式提示

作者推测,可能不是提示工程不行,是这俩模型理解能力不行,它们目前的水平还无法严格遵守人类的指令。

于是,他们又在ChatGPT上试了一下,结果不出所料,e变i了。

因此说明,提示工程有用,但要看是谁。

接着,作者又开始思考,那么到底是什么影响了大模型的人格呢?

提出的假设是训练数据集(好比成长环境)。

由此,开始解决第三个问题:

训练数据集对模型人格的影响有多大?

实验方法是用不同的语料库来训练同一个模型,具体而言就是在Bloom和llama-v2上分别用中文维基百科语料库、问答语料库和考试语料库分别进行训练再测试。

结果是除了i和e,这俩模型基本都有变化(llama-v2在中文维基百科语料库上没变可能是因为该模型之前就没有再足够多的中文上训练过),尤其在T/F和J/P维度上的得分幅度变动较大。

靠谱吗?

最后,想必你也会问:

用MBTI来评估模型人格到底靠谱吗?

作者认为:

首先,我们知道MBTI在可靠性和有效性方面其实还存在缺陷,只能作为一种性格测试的参考工具。不过确实也有公司和个人把它用作选人和选职业方向的粗略工具。

因此,它也可以作为评估大模型的一种粗略的指标。

其次,在MBTI的四个维度之中,前俩参考意义不大,主要是T/F和J/P。

这是鉴于GPT-4和ChatGPT表现出比其他模型高得多的T值和J值。

而这俩值越高,可能说明模型的知识水平以及任务分解和路径规划方面具有更大的潜力。

以上,你认可这些大模型的“人格”吗?

论文地址:

https://arxiv.org/abs/2307.16180

本网站所有内容来源注明为“梅斯医学”或“MedSci原创”的文字、图片和音视频资料,版权均属于梅斯医学所有。非经授权,任何媒体、网站或个人不得转载,授权转载时须注明来源为“梅斯医学”。其它来源的文章系转载文章,或“梅斯号”自媒体发布的文章,仅系出于传递更多信息之目的,本站仅负责审核内容合规,其内容不代表本站立场,本站不负责内容的准确性和版权。如果存在侵权、或不希望被转载的媒体或个人可与我们联系,我们将立即进行删除处理。

在此留言